- Dettagli

- Scritto da Administrator

di Luca Mazzucato

di Luca Mazzucato

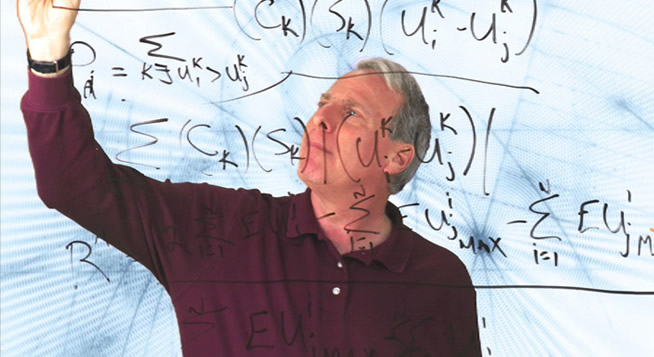

NEW YORK. Tarocchi, divinazioni, maghi telegenici: per aprire una finestra sul futuro ci si presta alle pratiche più improbabili. Ciò che i fondi di caffè non potranno mai dirci, si può però scoprire con la matematica: grazie alla teoria dei giochi siamo ora in grado non solo di predire il futuro, ma di piegarlo ai nostri interessi. Bruce de Mesquita, professore di scienze politiche alla New York University, ha sfruttato appieno la potenza predittiva di questa disciplina e ne svela i segreti nel suo ultimo libro “The predictioneer's game,” ovvero “Il gioco del divinatore.” Riusciranno i leader mondiali a trovare un accordo per bloccare le emissioni di gas serra e salvare il pianeta dall'ebollizione? Gli iraniani costruiranno la bomba o abbandoneranno il programma nucleare? Come si può risolvere il conflitto tra israeliani e palestinesi?

Questo è il genere di problemi a cui si dedica Bruce Bueno de Mesquita. Usando la teoria dei giochi, de Mesquita ha elaborato un modello matematico che riesce a predire l'esito di situazioni complesse, basandosi su una semplice ma geniale assunzione: ogni decisione che prendiamo è tesa a massimizzare il nostro tornaconto personale. Secondo la teoria dei giochi, sviluppata a partire dagli anni cinquanta da John von Neumann (ovvero il “Dottor Stranamore”) e John Nash (il matematico del film “A beautiful mind”), l'uomo è un essere razionale, nel senso che le sue decisioni sono prese in base al proprio esclusivo interesse. A parte i neonati e gli schizofrenici, tutti gli esseri umani sono razionali, inclusi i kamikaze, Madre Teresa e Ahmadinejad. Ma come funziona in pratica questo modello matematico?

L'idea è molto semplice. Per fare un esempio concreto, prendiamo il programma nucleare iraniano. Prima di tutto, dobbiamo identificare i vari giocatori della partita e l'obiettivo che ciascuno di loro vuole raggiungere, ma anche quello che viene dichiarato pubblicamente, perché una parte essenziale del gioco è il bluff. Nel nostro esempio, gli attori sono l'ayatollah Khamenei, il presidente Ahmadinejad e i movimenti politici e gruppi economici iraniani, oltre alle potenze straniere. Nel gennaio 2009, lo scopo dichiarato del regime era di costruire centrali nucleari, mentre l'obiettivo reale era arricchire abbastanza uranio per produrre una bomba, ma senza produrla realmente.

A questo punto, dobbiamo valutare altri due fattori: quanto è importante il programma nucleare per ciascuno dei giocatori, rispetto agli altri grattacapi di cui si deve occupare, e il potere effettivo che ciascuno è in grado di esercitare per ottenere il proprio obiettivo. Tutte queste informazioni, che sono l'input da fornire al modello, non sono il frutto di rapporti top secret della CIA, ma si tratta più semplicemente di fatti reperibili sul New York Times o su Wikipedia.

Nel caso di un negoziato politico, lo scopo di tutti gli attori è non solo il raggiungimento del proprio obiettivo, ma anche il riconoscimento pubblico del ruolo svolto. È cruciale capire se per ciascun giocatore sia più importante il riconoscimento del proprio impegno rispetto all'ottenimento dell'obiettivo stesso. Per esempio, giocatori con posizioni pregiudiziali di solito sono più interessati a dimostrare la propria “integrità morale” che ad ottenere gli obiettivi per cui si battono.

Un fattore che invece non compare affatto nel modello è la storia passata delle parti in causa. Le loro decisioni precedenti non concorrono in alcun modo nel determinare il loro futuro comportamento, al contrario di quanto si potrebbe pensare. La matematica ci insegna che il senso comune in questo caso è proprio sbagliato. Una volta impostate queste condizioni, de Mesquita preme il tasto Invio e aspetta che il computer faccia girare il suo modello matematico, che peraltro l’ha reso milionario grazie alla sua società di consulenza.

Qual è la predizione del modello sul futuro del programma nucleare? Entro l'estate 2010 il regime iraniano abbandonerà la costruzione della bomba e si dedicherà all'arricchimento per scopi civili e di ricerca. In questo modo, l'Iran soddisferà l'orgoglio nazionale, dimostrando ai vicini di possedere in caso di bisogno la tecnologia necessaria a costruire la bomba, ma non la costruirà nella pratica. Inoltre, le pressioni internazionali e le eventuali sanzioni avranno l'effetto opposto di posticipare di qualche mese l'abbandono del programma nucleare militare.

Possiamo fare altre domande all'oracolo informatico. Chi comanderà in Iran fra un anno? Il modello predice che fra un anno l'influenza politica di Ahmadinejad sarà sparita, mentre gli ayatollah radicali segneranno il passo rispetto a quelli più moderati e riformisti della zona di Qum. L'attuale conflitto politico lascerà un unico vincitore: gli interessi economici dei petrolieri e dei commercianti, che determineranno il futuro del paese. Il professore ci insegna che non tutto si può predire: per esempio l'andamento del mercato azionario sfugge alla teoria dei giochi. Ma una volta acquisita la capacità di predizione, il passo successivo è come sfruttare questo modello per guidare gli eventi nella direzione da noi voluta. Si tratta di una nuova scienza che de Mesquita chiama “ingegneria politica.”

Il paragone con il mondo fantascientifico della Fondazione, inventato da Isaac Asimov, è assolutamente calzante. Il nostro professore altri non é se non Hari Seldon, il protagonista della serie fantascientifica che usa un modello matematico per manipolare il futuro dell'umanità dopo la caduta dell'impero galattico. Una volta acquisita la capacità di predire l'effetto delle nostre ipotetiche scelte, possiamo scoprire quale opzione ci permette di ottenere il risultato voluto al costo minore. Il limite fino a dove ci possiamo spingere nel futuro è determinato soltanto dalla potenza di calcolo a nostra disposizione.

Questo è proprio quello che fa de Mesquita. La società di consulenza fondata dal professore viene spesso chiamata dalla CIA e dal Dipartimento di Stato americano per cercare di capire come gestire le crisi più complesse. Un recente documento della stessa CIA ha rivelato che, nei casi in cui tutti i cosiddetti “esperti” dell'agenzia hanno toppato alla grande, le predizioni del modello matematico di de Mesquita sono state esatte il 90% delle volte.

Ma il modello di de Mesquita si può utilizzare anche retroattivamente, per fare della fantapolitica. Per esempio, può essere studiato per capire quali eventi storici si sarebbero potuti cambiare e in che modo. Nel suo libro non mancano le succose divagazioni su molti degli episodi più controversi della storia mondiale. Per esempio, come si sarebbe potuta evitare la prima guerra mondiale se gli inglesi avessero spedito una nave da guerra in crociera nel mare Adriatico. Oppure come il Reichstag avrebbe potuto fermare Hitler nel 1932, se socialdemocratici e comunisti avessero eletto a cancelliere il leader del partito centrista cristiano-democratico. Se volete scoprire cosa ne sarà del riscaldamento globale o del processo di pace in Medioriente, non vi resta che ordinare il libro, per ora disponibile soltanto nell'edizione americana.

- Dettagli

- Scritto da Administrator

di Liliana Adamo

di Liliana Adamo

Se nella vita e nella mente di un uomo si può celare un ginepraio da cui affiorano cause e motivazioni (vere o presunte) a decifrare il perché di un gesto talmente spropositato agli occhi di qualsiasi persona comune, allora, nella storia personale del soggetto in questione, nei comportamenti, nelle scelte, o in quant’altro possa ascriversi nella soggettività e nel carattere, il gap tra follia e controllo è sempre pronto a esplodere.

Trentanove anni, single, laureato in biochimica al Virginia Tech (già teatro di un massacro nel 2007), specializzato alla rinomata Herbert School of Medicine del Maryland e psichiatra dell’Us Army, dal 6 novembre scorso la vita e la mente del maggiore Nidal Malik Hassan, sono state esaminate e scandagliate pezzo per pezzo. Sbandierate ai quattro venti le origini palestinesi, la religione musulmana, il malcontento e l’avversione per la prossima missione al fronte iracheno, dove avrebbe sperimentato su di sé, lo stress e gli effetti devastanti della guerra, come in quei reduci assistiti durante il suo tirocinio con il grado di “counselor psichiatrico” al “Walter Reed Center”. Aveva perfino ingaggiato un avvocato per giungere a un compromesso con l’esercito degli Stati Uniti e quando l’accordo è stato rigettato, Hasan, non è andato in guerra, l’ha scatenata all’interno dell’esercito americano.

Certo, siamo a Killeen, in Texas, dove raptus omicidi e angeli sterminatori sono di casa: nel 1991, George Hennard jr, disoccupato, già arruolato nella Marina, bianco, omofobo e razzista, entra col suo pick up in un popolare ristorante self service e fa fuori ventitré persone prima di togliersi la vita. Nel 1993, nella vicina Waco, gli stessi agenti federali trucidarono settantaquattro, tra uomini, donne e bambini, asserragliati nel ranch dei davidiani. Si levano, di tanto in tanto, le diatribe per l’ormai arcinota deregolamentazione sul libero possesso delle armi, un “bene” d’uso comune, che, in pratica, implica tutti i substrati della società texana e non solo.

La stessa Fort Hood, la più grande base militare in territorio statunitense, detiene il record di soldati uccisi in Iraq e Afghanistan - 685 - a oggi. Nello stesso periodo, a Fort Hood, si sono suicidati settantacinque soldati, dieci, nell’arco di quest’anno. Tutta questa virulenza e disperazione hanno convinto il tenente generale Rick Lynch, a creare, all’interno della base, una struttura adibita al recupero per sindrome da stress post traumatico, il Resiliency Campus, che comprende un Centro Benessere Spirituale per la meditazione e un altro per il Potenziamento Cognitivo.

Insomma, propedeutica spirituale per affrontare gli orrori della guerra. Ma questa è solo una divagazione sul tema che s’intende trattare. Tornando a Nidal Malik Hassan, la matrice della strage sarebbe stata l’imminente partenza, oppure le discriminazioni subite da parte dei suoi colleghi in divisa, o ancora, il gesto conclusivo di una reazione personale, legata all’indole (del musulmano matto) e al momento difficile. Tranne che per Paul Joseph Watson del Prison Planet, nessuno, tra i promotori mediatici dell’establishment americano, sembra chiedersi se il medico psichiatra, autore della strage di Fort Hood, facesse uso di farmaci psicotropi, in una sorta di “auto-cura”, cui ricorrono molti degli stessi psicopatologi.

La somministrazione di farmaci psicotropi ai militari americani e la faciloneria con la quale questi prodotti sono impiegati anche in casi meno appropriati, sono ormai cosa nota. Ed è nota anche la casistica d’effetti collaterali in comportamenti che sfociano in suicidi e omicidi. L’uso indiscriminato degli SSRI, vale a dire, inibitori della ri-captazione della serotonina, è veramente azzardato nell’ipotesi in cui la depressione è di tipo post-traumatico, questa si affronta in terapia con supporti psicologici sostanzialmente diversi dalla farmacologia psichiatrica. Spingere il “malato” a uscire dal guscio in cui tenta di chiudere se stesso e il suo dolore con farmaci neurotonici che origineranno agitazione mentale e inquietudine (akathisia), sempre più pesanti da assimilare e da controllare, è come accendere una miccia a lenta combustione.

Il British Medical Journal, in un atto di coraggio, ha informato di tre studi clinici che indagano sul nesso tra impiego di farmaci antidepressivi, in particolare gli inibitori selettivi nel riassorbimento della serotonina (SSRI) e i rischi di suicidio e/o omicidio. Una revisione sistematica con approfonditi studi clinici è stata resa pubblica dai ricercatori dell’Health Reserch Institute, nell’Ontario. Ricercatori dell’University of Bristol e dell’University of London hanno compiuto successive analisi confrontando farmaci SSRI con il placebo nei pazienti adulti. Il risultato di questi screening è a dir poco sorprendente: l’esito è che la frequenza concernente l’ideazione suicidaria, l’autolesionismo, finanche l’omicidio, è stata enormemente sottostimata dalle case farmaceutiche e dagli studi precedenti.

Il rischio aumenta enormemente tra i pazienti di età uguale o inferiore ai diciotto anni, trattati con SSRI. E dunque se si dà una sbirciata alla letteratura clinica di questi antidepressivi, plausibile che ti si rizzino i capelli e se la medesima sbirciata si rivolge al volume d’affari delle case farmaceutiche coinvolte in quest’affare colossale, plausibile che ti si sbianchi anche il volto.

Sono motivazioni politiche, personali che rendono comprensibile l’ennesimo massacro? Può darsi. E’ chiaro, però, e su questo si alza un muro di silenzio se non di omertà, che in quasi tutte le sparatorie stragiste avvenute negli ultimi due decenni e cioè da quando l’uso dei farmaci antidepressivi è divenuto così massiccio e popolare, ogni volta l’omicida era sotto l’effetto di SSRI. Altra coincidenza, anche l’autore del massacro al Virginia Tech, Seung-Hui Cho, era sotto effetto di farmaci psicotropi.

Vogliamo andare avanti? Eric Harris e Dylan Klebold, artefici e ideatori del massacro nelle aule della Columbine, come il quindicenne Kip Kinkel, omicida dell’Oregon che assassinò i compagni di classe e i suoi genitori, erano sotto l’effetto del Prozac, notoriamente “pillola della felicità”, tra i più noti della nutrita compagnia degli SSRI. A Omaha, in Nebraska, Robert Hawkins che uccise con un fucile d’assalto otto persone prima di suicidarsi, aveva una storia personale puntellata da trattamenti psichiatrici per depressione e ADHD, controversa sindrome da deficit d’attenzione e iperattività; anch’egli, nel momento della sparatoria, era sotto Prozac. Così Jeff Weise, l’omicida della Red Lake High School, l’Unabomber, Ted Kaczinski, John Hinckley Jr, Byran Uvesugi, Mark David Chapman, Charles Carl Roberts, l’assassino della scuola Amish e Steven Kazmierczak, tutti erano sotto effetto di farmaci psichiatrici di nuova generazione o SSRI.

Ci si chiede se anche il maggiore Nidal Malik Hassan sia stato vittima di un processo perverso in cui gli affari dell’industria farmaceutica s’intrecciano con quelli dell’apparato militare, con l’incompetenza, l’analfabetismo di chi l’ha deciso. Lo psichiatra che spara all’impazzata contro chi doveva curare è la perfetta metafora che si ha oggi della psichiatria e della sua rete depressiva.

- Dettagli

- Scritto da Administrator

di Luca Mazzucato

di Luca Mazzucato

Eppur si muove: nonostante le infinite iatture fin qui incontrate, lunedì notte il Large Hadron Collider del CERN di Ginevra ha effettuato la prima collisione tra protoni all'energia di 500 miliardi di elettronvolt. Fino a Natale in fase di collaudo, dal 2010 l'acceleratore più potente mai costruito comincerà a svelare i misteri della struttura dello spazio e del tempo. Ma come in un romanzo di Philip Dick, alcuni credono che un segnale dal futuro ne saboterà il funzionamento...

In due parole, lo scopo di LHC consiste nel far girare in tondo ad una velocità prossima a quella della luce due fasci di protoni lungo un cerchio di ventisette chilometri. In due punti lungo il cerchio, i due fasci opposti di protoni vengono fatti scontrare, sprigionando un'energia mai raggiunta prima e facendosi beffe del celebre detto degli Acchiappafantasmi: “Mai incrociare i flussi!”

Rovistando tra le macerie di questo scontro titanico, grazie a degli enormi rivelatori i fisici teorici sperano di trovare le tracce del famoso bosone di Higgs, l'ultima particella mancante per confermare il nostro racconto del mondo microscopico. Proprio come un fantasma, infatti, il bosone di Higgs è riuscito ad eludere tutti i tentativi di osservazione compiuti finora all'acceleratore Tevatron di Chicago. LHC supererà in potenza il collega del Fermilab di quasi un fattore dieci e lo manderà in pensione dopo oltre vent'anni di attività.

Pronto per l'uso nell'estate 2008, LHC subì un primo catastrofico intoppo nel settembre dello scorso anno, quando una perdita di sei tonnellate di elio liquido dal sistema di raffreddamento dei magneti superconduttori danneggiò seriamente l'acceleratore, costringendo i tecnici a una sosta forzata di un anno intero.

L'origine di questo problema permette di capire una caratteristica straordinaria di LHC. Per far girare in tondo i protoni, che hanno carica elettrica positiva, é necessario forzarli con un campo magnetico. Più veloci i protoni, più potente il campo magnetico. Per produrre un campo magnetico si può usare della corrente elettrica, come succede per le elettrocalamite degli sfasciacarrozze. Quando la corrente elettrica scorre nei soliti cavetti di rame, li surriscalda, disperdendo calore a causa della loro resistenza. Il campo magnetico che bisogna produrre per costringere i protoni dentro al cerchio di LHC è enorme: tanto che la corrente necessaria per generarlo fonderebbe qualsiasi materiale esistente in natura.

Con un'eccezione: si tratta di un tipo di materiali dalle caratteristiche inverosimili, chiamati superconduttori. I superconduttori trasportano corrente, ma a differenza del doppietto di rame non possiedono alcuna resistenza e dunque non si surriscaldano e possono far andare l'acceleratore. L'unico problema è che questi materiali restano nello stato superconduttore solo a temperature molto basse ed è dunque necessario raffreddare i magneti con l'elio liquido a temperature (LHC è il luogo più freddo di tutto l'universo).

Un corto circuito ha bucato i contenitori di elio liquido causandone la fuoriuscita e bloccando la macchina per un anno. D'altra parte, il balzo tecnologico nello studio dei superconduttori, che ha permesso la realizzazione di LHC, avrà certamente grosse applicazioni nell'efficienza energetica: forse non è distante il momento in cui potremo trasportare elettricità senza alcuna perdita.

Il più recente intoppo subito dall'acceleratore di particelle è stato causato all'inizio di novembre da una baguette. Ricordate la celebre scena di Guerre Stellari in cui Luke Skywalker, guidato dalla Forza, riesce a centrare con un missile il condotto di raffreddamento della Morte Nera? Ebbene, un uccello ribelle in volo sopra le campagne francesi è riuscito a replicare l'impresa, centrando con un pezzo di baguette un punto sensibile di un macchinario esterno, causando un improvviso riscaldamento di LHC che ha portato al blocco di tutta la struttura. La notizia è confermata dal Dr. Mike Lamont, uno dei responsabili dell'esperimento.

Che LHC sia la macchina più potente e complessa mai concepita dall'ingegno umano è senz'altro vero. E' dunque inevitabile che nella fase di costruzione e di collaudo si applichi senza eccezioni la legge di Murphy: tutto quello che può rompersi si romperà. Ma un celebre fisico teorico danese, Holger Nielsen, del Niels Bohr Institute di Copenhagen, si è spinto oltre, formulando una teoria che invoca una sorta di censura cosmica, all'origine del “sabotaggio” della preziosa macchina.

La teoria è tanto balzana quanto suggestiva (anche se è di qualsiasi riscontro). Secondo Nielsen, qualche fenomeno fisico a noi (ancora) sconosciuto ci impedisce di creare il bosone di Higgs, una vera e propria forma di censura cosmica. Siccome LHC è stato progettato proprio con lo scopo di produrre e studiare questa particella nel futuro, questo fenomeno fisico sconosciuto sarebbe responsabile di quello che nel passato, cioè ora, sembra una serie incredibile di coincidenze e sfortune, ma il cui risultato finale è evitare che il bosone di Higgs veda la luce.

Gli aneddoti a favore di questa tesi sono numerosi. Prima dell'avvento di LHC, gli Stati Uniti avevano iniziato la costruzione del colossale Superconducting Super Collider, disegnato per produrre il bosone di Higgs e ben quattro volte più potente di LHC. Dopo aver speso due miliardi di dollari e scavato un enorme tunnel vicino a Dallas, in Texas, il Congresso americano chiuse l'esperimento, dirottando i fondi verso il progetto della Stazione Spaziale Internazionale: il bosone di Higgs dovrà aspettare. Nonostante anni di caccia forsennata, l'acceleratore Tevatron del Fermilab non è mai riuscito a produrre un solo bosone di Higgs, anche se l'ha cercato quasi ovunque (tranne nell'ultimo angolino buio dove punterà la luce LHC). Poi è accaduto l'episodio dell'elio liquido l'anno scorso, ora anche il mondo animale prova a mettere le baguette tra le ruote.

Ma per fortuna i cocciuti scienziati del CERN non si sono fatti intimidire e lunedì notte hanno infine puntato i due fasci di protoni uno contro l'altro, portando a termine con successo la prima collisione. Tutto è andato come previsto: la fase più critica dell'esperimento è dunque passata. L'energia sprigionata è per il momento molto inferiore a quella che servirà, a regime, per produrre l'Higgs. Finito il breve periodo di collaudo degli strumenti, entro i primi mesi del 2010 LHC aumenterà progressivamente l'energia, cominciando i primi esperimenti veri e propri.

I continui ritardi subiti dal progetto (oltre tre anni), oltre ad avere un costo elevato, hanno avuto una ricaduta pesante sulla principale forza motrice del CERN: gli studenti di dottorato. Centinaia di dottorandi che hanno costruito la macchina e attendono i primi dati si trovano in una situazione molto difficile. La maggior parte delle istituzioni europee richiede una durata massima di tre o quattro per scrivere una tesi di dottorato: chi aveva puntato sulla partenza dell'acceleratore nel 2006, posticipata di volta in volta fino al 2010, si è ritrovato con un pugno di mosche in mano e problemi a concludere il dottorato. Sono in molti dunque a sperare che questa sia la volta buona e, finito l'attuale collaudo, arrivino i primi risultati. A meno che non abbia ragione Nielsen e qualcuno lassù proprio non sopporti la vista del bosone di Higgs.

- Dettagli

- Scritto da Administrator

di mazzetta

di mazzetta

Le ultime settimane hanno registrato una serie di novità che riguardano l'assetto e il futuro della rete. L'ICANN (l'organismo che regola i nomi dei siti) ha disposto l'introduzione delle denominazioni dei siti con alfabeti diversi da quello latino, l'arabo, il cirillico, il cinese, il giapponese, il coreano, l'ebraico o l'hindi avranno quindi cittadinanza in rete fin dalla composizione dell'indirizzo (o dominio), mettendo fine al monopolio dell'alfabeto latino, una rivoluzione culturale passata per lo più inosservata, la fine del dominio latino sul dominio Internet.

Sembra finalmente destinato a decollare anche l'IPV6, il protocollo internet a 128 bit destinato a sostituire l'IPV4 che di bit ne ha solo 32. Il protocollo IPV6 permette di avere a disposizione una quantità sterminata di nuovi indirizzi (quelli di IPV4 sono prossimi all'esaurimento) e consente un uso ancora più versatile della rete. La penetrazione del protocollo IPV6 è ancora limitata all'uno per cento della rete, ma l'esaurimento della capacità dell'IPV4 costringe ormai a fare di necessità virtù e a muovere verso la nuova frontiera.

Frontiera che registra una vittoria sul fronte della neutralità della rete, la pretesa di alcuni operatori professionali di costituire corsie preferenziali per certi tipi di traffico (in genere quello commerciale in senso stretto) e punitivo per altri (in genere il file-sharing) ha subito una brusca sconfitta su tutta la linea, la neutralità della rete è stata quindi riaffermata, nessuna gerarchia nel traffico e nessuna corsia preferenziale, ma neanche colli di bottiglia a strozzare il traffico diretto verso siti sgraditi alle corporation.

In proposito giunge l'ultima evoluzione di Pirate Bay, la Baia dei Pirati che è l'incubo del fronte anti-pirateria in quanto epicentro dell'ultima generazione appassionati della condivisione peer-to-peer gratuita di contenuti digitali. Dopo la vendita del sito, i tecnici pirati hanno annunciato il pensionamento del vecchio sistema centralizzato di gestione dei link ai torrent in favore di uno diffuso, nel quale Pirate Bay assumerà la forma di un motore di ricerca per i torrent in condivisione, con il doppio risultato di rendere più stabile il servizio (si spera) e di sottrarsi alle pressioni legali delle corporation che hanno dichiarato guerra al file-sharing.

Guerra che procede male per gli alfieri del copyright, alcuni paesi europei come Francia e Gran Bretagna stanno cercando di promulgare leggi punitive nei confronti di chi scarica illegalmente contenuti dalla rete, ma con scarso successo. Nessun paese occidentale è ancora riuscito ad immaginare una regolamentazione che riesca a limitare il fenomeno senza comprimere pesantemente i diritti individuali, tra i quali molti paesi stanno riconoscendo proprio l'accesso alla rete.

Il confronto tra la rete e gli altri media continua ad essere aspro, nonostante il passare degli anni abbia portato ad un'integrazione sempre più spinta tra i diversi media. Se la radio regge il confronto e sembra anzi trarre ossigeno dalle possibilità offerte da streaming e podcasting, televisione e carta stampata arrncano, perdendo utenza e introiti in favore della rete. Soldi pesanti, quelli della pubblicità, ma anche un preoccupante calo della rilevanza e dell'impatto sulla formazione delle opinioni pubbliche, questi i motivi che spingono molti editori a scendere in guerra contro la rete. Poco importa che le loro edizioni si riempiano con poca fatica attingendo alla rete, per lo più senza riconoscerlo in alcun modo, gli editori vogliono difendere il loro prodotto, ma non hanno alcuna remora ad appropriarsi del contenuto pubblicato in rete. Recentemente ha fatto rumore il brutale plagio operato da una famosa conduttrice di programmi culinari in televisione, che ha pubblicato un fortunato libro di ricette copiando a man bassa da quelle rinomate di una blogger, notizia che però non ha raggiunto i telespettatori e i lettori che non hanno accesso alla rete.

Una delle battaglie più significative di questa guerra è quella che vede Google confrontarsi con gli editori che accusano l'azienda di Mountain View di sfruttare illegalmente i contenuti prodotti dai giornali. Un'accusa diffusa un po' ovunque nel mondo e se Rupert Murdoch è quello che fa più rumore, anche nel nostro paese si sono registrati attacchi a Google da parte degli editori. Il modello di business di Google è agli antipodi di quelli dell'infotainment televisivo e dell'editoria ed è abbastanza normale che i due mondi fatichino a capirsi,il delta culturale è vasto e non sembra che le intelligenze capaci di colmarlo attirino l'attenzione degli editori.

Murdoch è riuscito a rendersi ridicolo, minacciando Google di togliere l'accesso di Google News alle sue testate e accendendo una polemica al termine della quale si è capito solo che Google lo innervosisce perché riesce a guadagnare con la rete mentre le sue aziende ci perdono. L'ultima uscita di Murdoch in realtà è stata stimolata proprio da una disavventura con Google, nei giorni precedenti l'attacco Murdoch aveva saputo che avrebbe incassato cento milioni di dollari in meno del previsto da Google, perché in un accordo relativo a MySpace il sito di Murdoch non ha raggiunto gli obbiettivi fissati contrattualmente da Google per l'erogazione dei cento milioni.

Le disavventure di MySpace, penalizzato dall'affermarsi di Facebook, si aggiungono a quelle del Wall Street Journal, recente acquisizione del magnate australiano, che ha pensato bene di mettere a pagamento l'edizione online del giornale, decisione che ha comportato un crollo delle visite al sito, che così ha accompagnato il crollo delle vendite delle copie di carta a seguire il calo di credibilità della testata, in questo caso è il nome di Murdoch ad essere un problema perché non è certo un sinonimo di attendibilità, un requisito fondamentale per chi legge un quotidiano economico. A prescindere dalla qualità del WSJ, il tentativo di Murdoch rappresenta un po' il tentativo di “rimettere il genio nella bottiglia” dopo che ne scappato, come h notato Biza Stone, uno dei fondatori di Twitter.

Male anche per il Washington Times e l'agenzia UPI, travolti dalla lotta per la successione tra i figli del reverendo Moon, che è ancora vivo, ma che ha perso un po' di smalto. Nel ventunesimo secolo essere a capo della Lega Anticomunista Mondiale e allo stesso tempo della Chiesa Dell'unificazione e proclamarsi Dio cristiano in terra, non rende più come un tempo, se l'editoria classica soffre, la macchina di Moon è al disastro, superata a destra da una miriade di siti molto più estremi e in fondo divertenti. Al Washington Times il confronto ha visto in redazione anche la presenza di guardie armate e per un attimo la poderosa macchina da propaganda del reverendo coreano è sembrata fermarsi. Merita ricordare che il Washington Times e l'UPI sono state “le fonti” delle peggiori mistificazioni dei neo-conservatori americani, ripetute identiche dalla maggior parte dei media nostrani, senza mai sottolineare la peculiarità della fonte.

Se il reverendo coreano è il diavolo quando tenta Milingo, quando ha inventato balle per spingere l'Occidente alla guerra è stato trattato e presentato ai lettori dei media italiani come se fosse il Washington Post. Anche i media italiani sono schierati con Murdoch nella battaglia contro Google e così capita che nella mischia finiscano per fare brutta figura in parecchi al seguito dell'australiano. Una menzione la merita Massimo Mucchetti, che dalle pagine del Corriere della Sera scrive in propostio un lungo articolo, fondato però su almeno un paio di bugie grosse e sull'evidente necessità di piegare il discorso all'esito desiderato. Non è che Google non offra motivi d'apprensione nella sua tumultuosa espansione, ma la concorrenza che inventa storie per darsi ragione non fa un bell'effetto.

Fa imbestialire i professionisti impegnati in modelli di business tradizionali, perché Google fa soldi dove gli altri non riescono a fare soldi e allo stesso tempo colonizza nuovi spazi (anche quelli futuribili) con investimenti massicci che ai concorrenti sembrano a fondo perduto. Google in realtà non si comporta in maniera originale, ma semplicemente congrua al momento storico e allo stato dell'ambiente nel quale è chiamata ad operare, tumultuoso e in espansione geometrica. Percorre una strada aperta prima da IBM e poi ribadita da Microsoft, cercando di difendere e consolidare la posizione centrale che ha conquistato nel mercato dell'IT, ma soprattutto proiettandosi in un futuro nel quale la rete sarà enormemente più diffusa, potente e capiente.

Microsoft stessa tenta da sempre di colonizzare lo spazio elettronico e di dividerne i mercati verticalmente ed è di questi giorni una sua decisa reazione contro la pirateria, consistente nel divieto di accedere alla piattaforma di gioco online per Xbox agli utenti che hanno modificato le console di gioco per poter utilizzare giochi piratati, già più di un milione di possessori di Xbox sono stati bannati dalla piattaforma di gioco.Da qui l'ostilità da parte degli attori che perseguono modelli tradizionali di business, rinfocolata da dati che vedono aumentare l'utenza (e il business) in rete e calare l'audience dei media tradizionali. Un'ostilità che in alcuni paesi può tramutarsi in un tacito ostruzionismo alla diffusione della rete, non solo da parte della politica sempre spaventata dall'esistenza di spazi di comunicazione incontrollati, ma anche da parte delle istituzioni finanziarie e di potenti interessi costituiti. Il nostro paese è uno di quelli nei quali la diffusione di Internet trova una forte opposizione da parte di questa variegata composizione d'interessi, figlia di carenze culturali pesanti, ma anche sostenuta da considerazioni e interessi più prosaici.

- Dettagli

- Scritto da Administrator

di Alberto Mazzoni

di Alberto Mazzoni

Una delle scoperte neuroscientifiche recenti che più ha colpito l'immaginario culturale è quella dei neuroni-specchio, cioè neuroni che si attivano sia quando una scimmia compie un movimento sia quando vede altre scimmie compierlo. Le conseguenze di questa evidenza sperimentale sono ancora da appurare, ma l'idea di aver trovato un tassello neurofisiologico dell'identificazione tra sè e l'altro è suggestiva. I neuroni specchio sono stati rilevati con registrazioni di potenziale elettrico da elettrodi collocati nel cervello, un tipo di esperimento che solo raramente (durante operazioni chirurgiche) viene praticato sull'uomo, e questo fa sì che ancora non ci sia prova diretta della presenza di neuroni specchio umani, anche se è ragionevole supporre che ve ne siano.

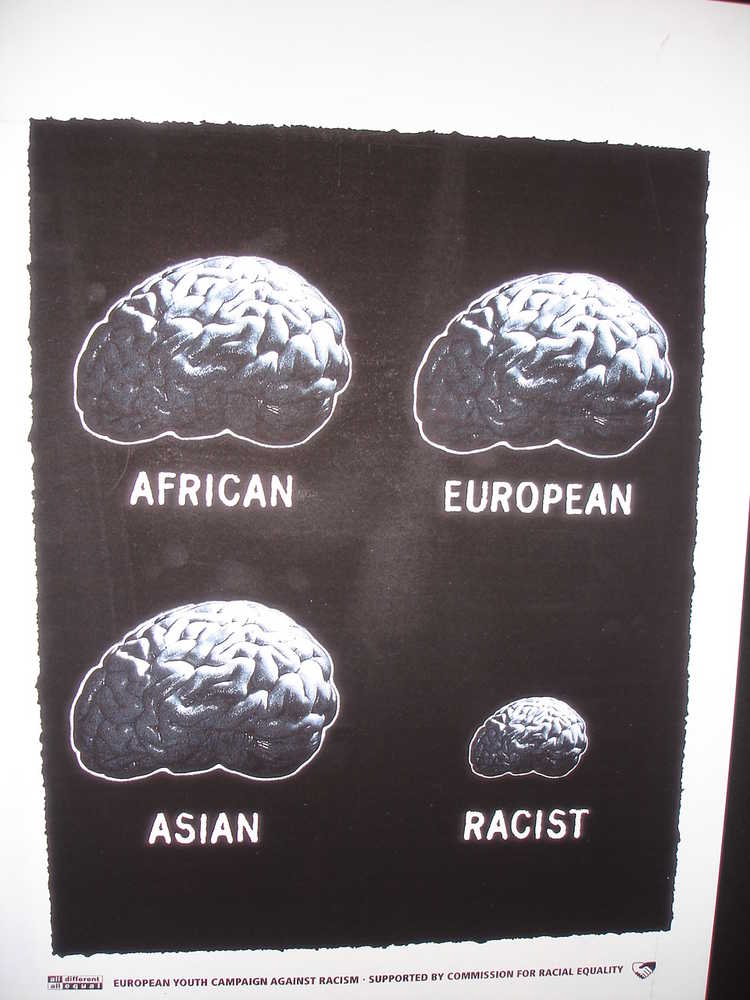

La maggior parte delle registrazioni dell'attività cerebrale umana deriva dall'elettroencefalogramma, cioè dal potenziale elettrico misurato attraverso il cranio, o dalla risonanza magnetica, che misura il livello di consumo di ossigeno del cervello e quindi il suo livello di attivazione. In entrambi i casi si tratta di misurazioni che riguardano aree del cervello, e non singoli neuroni. Tramite la risonanza magnetica si è scoperta un'area con proprietà empatiche, chiamata corteccia cingolare anteriore, che si attiva sia in corrispondenza del proprio dolore che in corrispondenza della vista del dolore altrui, come dimostrato da numerosi esperimenti. Nessuno aveva però mai avuto l'ardire di porsi la domanda alla base della ricerca che un gruppo di neuroscienziati cinesi ha pubblicato recentemente su Journal of Neuroscience: l'empatia dipende dall'etnia? Sono più sensibile se vedo soffrire una persone del mio stesso gruppo etnico?

Il test è stato svolto su 17 cinesi e 16 caucasici, di cui viene misurata l'empatia nei confronti di modelli cinesi e caucasici che, in un video, vengono toccati nella guancia con la punta di un cotton-fioc o con la punta di un ago. In nessun caso i modelli cambiano espressione, in maniera tale che l'esperimento sia indipendente dai codici facciali culturali, assai diversi tra Asia e Europa. Un primo test dimostra sulla base di un set di domande che i due gruppi di soggetti sono diversi come criteri morali (come da stereotipo, i cinesi sono più collettivisti e i caucasici più individualisti etc).

Il secondo test si basa sulle risposte dei partecipanti al test alle domande I) pensi che la persona stia provando dolore? II) questo ti fa star male? Il risultato è che, indipendentemente dall'etnia del soggetto che guarda e del soggetto ripreso, se si reputa che la persona stia provando dolore nel 90% dei casi si ritiene la vista del dolore sgradevole per sè stessi. O almeno si dice di ritenerla sgradevole. Il terzo test consiste nel misurare l'attività della corteccia cingolare anteriore tramite la risonanza magnetica. Il risultato è che per entrambe le etnie la corteccia cingolare anteriore aumenta la propria attività esclusivamente se il modello sofferente è della propria stessa etnia. Esclusivamente. Il fenomeno è simmetrico: la corteccia cingolare anteriore dei caucasici ignora la sofferenza dei cinesi e viceversa, quindi questo non dipende dalle differenze culturali evidenziate dal primo test.

Nessuno è così riduzionista da credere che la risonanza magnetica di una singola area sia una misura completa dell'empatia, ma resta il fatto che esiste almeno una zona del cervello che si attiva per il nostro dolore personale, per quello dei nostri simili, ma non per il dolore di chi è etnicamente diverso da noi. Del resto, come fanno notare gli autori, la maggiore empatia verso quelli che ci sono etnicamente affini ha probabilmente un vantaggio evoluzionistico in una società animale. Questo non elimina la presenza di una naturale empatia umano-umano, ma la rende differenziata, graduata in base alla somiglianza, all'appartenenza al medesimo ceppo etnico.

Le risposte al secondo test erano quindi false? Non necessariamente. Ci sono numerosi istinti che negli esseri umani vengono superati dal ragionamento simbolico e dall'apprendimento sociale che conducono a comportamenti opposti a quelli istintivi. Un lavoro culturale è quindi necessario per compensare le influenze innate alla segregazione, e per farlo può essere utile conoscere il dato biologico di partenza.